Forschungsprofil Udo Frese

Mein Forschungsschwerpunkt ist Multisensordatenverarbeitung in Echtzeit, wie sie sich besonders für humanoide Roboter mit ihren vielfältigen Wahrnehmungsmodalitäten anbietet.

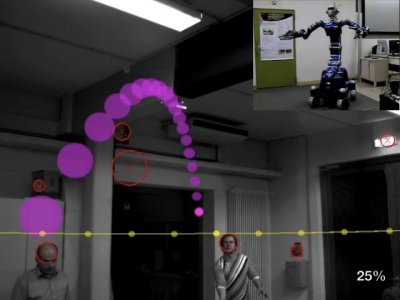

Das beste Beispiel für diese Philosophie ist unser Kooperationsprojekt B-Catch mit dem DLR / Institut für Robotik und Mechatronik (Abb. rechts). Dem humanoiden Roboter Justin werden dabei zwei Bälle zugeworfen, er verfolgt diese visuell und fängt jeden mit einer Hand. Diese Aufgabe ist für einen humanoiden Roboter anspruchsvoll, weil sich die Kameras am Kopf mit dem Körper mitbewegen und allein schon durch die Reaktionskräfte der Armbewegungen wackeln. Deshalb nimmt ein Inertialsensor diese Eigenbewegung wahr und wird im Tracker mit den Daten visuell erkannter Kreise fusioniert. Dafür setzen wir probabilistische Methoden ein, um zwischen dem wirklichen Ball und Fehlkreisen, z.B. Köpfen von Zuschauern, zu unterscheiden. Dadurch erkennt das System einen Ball daran, dass er sich wie ein Ball bewegt und setzt keinen statischen Hintergrund oder eine bestimmte Farbe voraus. Eine große Herausforderung war es dabei, Bildverarbeitung und Tracking in Echtzeit auf einem eingebetteten PC zu realisieren.

Diese probabilistische Fusion unterschiedlicher Sensoren und zeitlicher Sequenzen eines Sensors in Echtzeit ist charakteristisch für meine Arbeit.

Sportrobotik

Warum sollten Roboter Sport treiben, z.B. einen Ball fangen? --- Mit einem Roboter solch eine sportliche Aktivität zu realisieren, ist in zweierlei Hinsicht wertvoll:

Zum einen ist eine derartige Vorführung ungemein faszinierend, besonders für das fachfremde Publikum. Menschen sind Meister sportlicher Betätigung, von daher können selbst Laien unmittelbar und zutreffend beurteilen, wie gut ein Roboter bei der Ausübung eines Sports ist oder wie weit er noch vom menschlichen Vorbild entfernt ist. Ich sehe darin einen durchaus wichtigen Beitrag für die Robotik und sogar einen kulturellen Beitrag insgesamt, weil so unmittelbar anschaulich eine Auseinandersetzung über das Verhältnis zwischen Mensch und Roboter angestoßen wird. Der andere Aspekt ist, dass Sport eine enorme Herausforderung an Wahrnehmung und Bewegung bzgl. Geschwindigkeit, Präzision und Robustheit darstellt. Deshalb ist er eine ideale Benchmarkanwendung, um methodisch etwas über Echtzeitwahrnehmung und Echtzeitbewegungssteuerung, zwei zentrale Themen in der Robotik, zu lernen.

Das mittelfristige Ziel ist, den Wahrnehmungsteil des anvisierten Mensch-Roboter-Fußballspiels 2050 zu realisieren. Dabei haben wir uns auch mit den Aspekten physischer Interaktion bei dieser Vision beschäftigt.

Sportrobotik wird häufig zwar als schwierige technologische, methodische und wissenschaftliche Herausforderung, aber nicht als ernsthafte Anwendung gesehen. Vor kurzem entstand jedoch in meiner Arbeitsgruppe eine Idee zu einem Sportrobotik-Unterhaltungs-Szenario mit direkter Mensch-Roboter-Interaktion in einer Form, die ich für kommerziell realistisch halte. Unterhaltung ist natürlich eine ernsthafte Anwendung (Umsatz der Computerspielbranche in Deutschland 2008: 1,57 Mrd. Euro) und wir haben schon Kontakt zu einer Eventagentur, die sich dafür interessiert. Natürlich steht und fällt so ein Eventmodul mit einer interessanten Ausgestaltung der Interaktion mit dem Spieler über den technischen Kern der Ballbeherrschung hinaus. Hier ergeben sich Anknüpfungspunkte zur Mensch-Maschine Interaktion.

Sichere Sensoralgorithmen

Wann immer Mensch und Maschine einen Arbeitsraum teilen, stellt sich die Frage der Sicherheit und zwar langfristig der zertifizierten Sicherheit, z.B. vom TÜV nach EN 61508. Ein Beispiel ist die Kollisionsvermeidung für Fahrzeuge im Projekt Sicherkeitskomponente für Autonome Mobile Systeme (SAMS), BMBF-Initiative Servicerobotik. Der industrielle Stand der Technik in diesem Feld ist mit einem Laserscanner von Hand konfigurierte Schutzzonen zu überwachen. Im Projekt SAMS haben wir einen Algorithmus zur dynamischen Berechnung der Schutzfelder abhängig von der Bewegung des Roboters entwickelt und mit Hilfe von Computer unterstützter Softwareverifikation die Implementierung beim TÜV Süd nach EN 61508 SIL 3 zertifiziert. Dies ist ein Beispiel für komplexe sicherheitsgerichtete Algorithmen, die langfristig für humanoide Roboter unabdingbar sind.

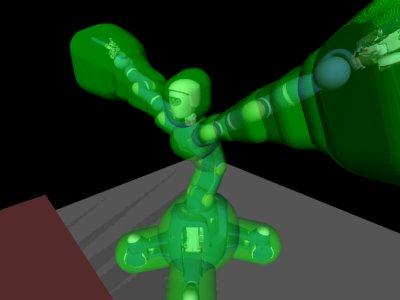

Mittlerweile haben wir das Verfahren auf 3D generalisiert, um humanoide Roboter und allgemeine bewegte Anlagen absichern zu können. Hierbei wird in Echtzeit der Raum (als Teilmenge von R^3) berechnet, der beim Bremsen überstrichen wird. Durch Testen dieser Volumina auf Schnitt werden Eigenkollisionen rechtzeitig verhindert. Das Verfahren ist z.B. beim DLR auf dem Roboter Justin im Einsatz und sichert das Ballfangen ab (Abb. oben). Außerdem bestehen Kontakte zum ANKA in Karlsruhe mit dem Ziel Diffraktometer vor Eigenkollisionen zu schützen.

Diese Arbeiten sind sehr industrienah. SAMS und iGEL sind Projekte mit Industriebeteiligung. In SAMS-3D bin ich Ko-Erfinder eines zum Patent angemeldeten Verfahrens. Das Projekt European Train Control System (ETCS) war ein Gutachten im Industrieauftrag.

Simultaneous Localization and Mapping (SLAM)

SLAM hat die Aufgabe, unsichere lokale Information zu einer globalen 3D-Karte zusammenzusetzen. Idealerweise betrachtet z.B. ein humanoider Roboter seine Umgebung und erhält hinterher ein dichtes 3D-Modell, wie in der Computergrafik üblich. Häufig reicht auch die Position einzelner markanter Punkte, wodurch die Bewegung rekonstruiert wird. Die Herausforderung liegt darin, dass nach jedem Schritt eine aktualisierte Karte gewünscht ist, so dass diese schnell und inkrementell berechnet werden muss. Der von mir entwickelte Treemap-Algorithmus leistet dies und hält einen Weltrekord bzgl. der Kartengröße. Im ersten Schritt ist SLAM passiv, mit der Minimum-Expected-Entropy-Methode kann aber z.B. der Kopf oder der ganze Roboter so gesteuert werden, dass der Informationsgewinn maximiert wird. Dank des SLAM unterliegenden probabilistischen Paradigmas lässt sich so eine aktive Komponente methodisch stringent integrieren.

SLAM hat viele Anwendungen, die ich mir für Folgeprojekte vorstellen kann: Es ist eine essentielle Funktionalität für mobile Serviceroboter, da es erlaubt, die zum Navigieren notwendige Karte "einzulernen", indem man den Serviceroboter einmal durchs Gebäude "führt". Für einen humanoiden Roboter bieten sich Kameras im Kopf fusioniert mit einem Inertialsensor an. Er verleiht einen absoluten Sinn für "unten" und einen störungssicheren Sinn für die relative Bewegung, wenn auch mit akkumulierendem Fehler. Bei der Bildverarbeitung hingegen akkumuliert der Fehler nicht, dafür kann sie ausfallen, weil im Bild nichts erkannt wird. Diese Kombination ist vorteilhaft komplementär und eines meiner Forschungsthemen. Dabei ermöglicht eine generische Software-Architektur, basierend auf sogenannten Mannigfaltigkeiten, verschiedene Sensoren und Informationsquellen zu integrieren.

SLAM ist mein langjähriger Hauptschwerpunkt und in großen Teilen gelöst. Daher habe ich den Fokus verschoben auf Anwendungen von SLAM in einem Gesamtsystem wie einem humanoiden Roboter und auf verwandte Probleme. Ein Beispiel dafür sind die verschiedenen Kalibrierungsaufgaben eines humanoiden Roboters (Kinematik, Kameras, Inertialsensor). Hier erlauben probabilistische Methoden wie in SLAM ein Lernen der Kalibrierung während des Betriebes oder zumindest eine stark vereinfachte Kalibrierprozedur.

In der Tradition meiner Arbeit im SFB/TR 8 Raumkognition ist mir auch der Bezug zur menschlichen Kognition wichtig. Psychologische Untersuchungen zeigen, dass beim Menschen topologische und semantische Aspekte eine wichtige Rolle in der Raumwahrnehmung spielen. Im Gegensatz dazu steht die bisher vorwiegend metrischen Herangehensweise bei SLAM. Hier möchte ich Repräsentationen finden, die beides kombinieren und damit auch als Raumrepräsentation für Manipulation fungieren können.

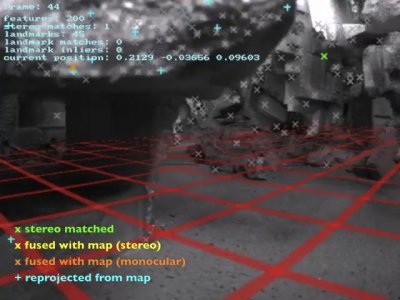

Mein Teilprojekt A7-[FreePerspective] im SFB/TR 8 Raumkognition adressiert eine andere Herausforderung zwischen menschlicher und technischer Raumwahrnehmung. Ein 3D-SLAM Verfahren soll Rettungskräfte beim Suchen nach von Erdbeben Verschütteten unterstützen~(Abb. oben). Ein Sensor an der Spitze eines Endoskops soll dazu den Trümmerhaufen erkunden, während dem Operator ein mitwachsendes 3D-Modell präsentiert wird.

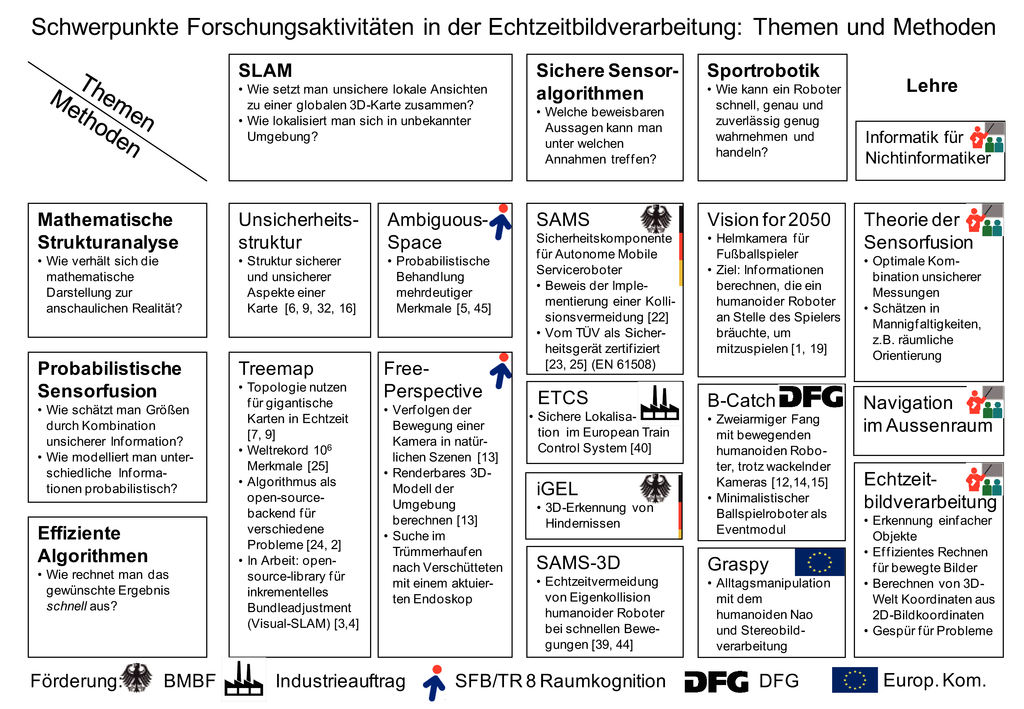

Orthogonal zu den Themen zeigt die linke Spalte der Tabelle übergreifende Methoden, die sich quer durch die verschiedenen Themen in unseren Projekten ziehen:

Mathematische Strukturanalyse

In meinem wissenschaftlichen Werdegang war immer eine Schlüsselfähigkeit, mathematisch-formale Repräsentation und Anschauung miteinander zu verknüfen und leicht zwischen beiden Seiten wechseln zu können. Diese Fähigkeit zur intuitiven Strukturanalyse ist enorm hilfreich, weil sie erlaubt, Ideen für Algorithmen zu entdecken, schwer zu entdeckende Fehler in Implementierungen zu finden und komplexe Zusammenhänge so darzustellen, dass der Zuhörer die Botschaft versteht.

Probabilistische Sensorfusion

Sensorfusion ist die Verknüpfung von unsicherer Information aus verschiedenen Quellen, um eine möglichst genaue Gesamtinformation daraus zu erhalten. Die Faszination an sensoriellen Daten liegt darin, dass sie an der Grenze zwischen der "realen Welt" und der "Welt im Rechner" liegen und die reale Welt eine Vielzahl an Phänomenen hat, die Sensordaten unsicher machen. Dieses gilt für Bilder in besonderem Maße.

Effiziente Algorithmen

Die Motivation für effiziente Algorithmen speist sich aus zwei Gedanken. Zum einen beschäftige ich mich mit Bildverarbeitung bei bewegten Vorgängen und da muss die Rechnung mit der Bewegung mithalten können (Echtzeit). Zum anderen ist Effizienz ein spannendes Forschungsziel an sich mit einem sehr klaren, weil gut messbarem Erfolgskriterium, der Rechenzeit. Daher übt Effizienz auf mich als Informatiker eine ähnliche Faszination aus wie Schubkraft auf einen Raketenentwickler.

Im Inneren der Tabelle finden sich Projekte und ihr Bezug zu den Themen und Methoden. AmbiguousSpace und FreePerspective sind von mir geleitete Projekte im SFB/TR 8, B-Catch ist ein DFG-Einzelprojekt, SAMS ist ein von mir mitgeleitetes Projekt in der BMBF-Initiative Servicerobotik und iGEL ein von mir mitgeleitetes Projekt im BMBF-Programm KMU Innovativ.