Aufgrund von Covid-19 und den damit einhergehenden Beschränkungen musste der Projekttag in seiner geplanten Form abgesagt werden.

Stattdessen stehen die Ergebnisse ab dem 01. Juni 2020 in digitaler Form auf einer Internetseite zur Verfügung.

Projekttag der Informatik 2020

Herzlich Willkommen!

Die Studierenden des Fachbereich Informatik der Universität Bremen stellen auf dem Projekttag am Freitag, 17. April 2020 die Ergebnisse ihrer Arbeit in den Bachelorprojekten vor.

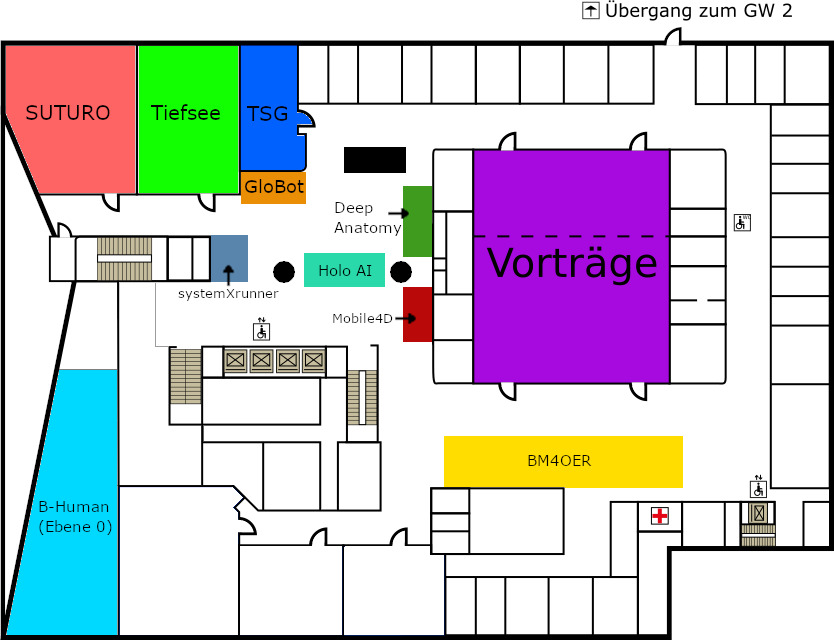

Ab 09:00 Uhr beginnen im MZH (Mehrzweckhaus, Bibliothekstraße 5) Vorträge, in denen die einzelnen Projekte vorgestellt werden. Neben diesen jeweils etwa 15 Minuten dauernden Kurzvorträgen sind Sie dazu eingeladen, an den Ständen der Projekte mit den Studierenden ins Gespräch zu kommen und dabei mehr über die Inhalte der Projekte zu erfahren.

Projektübersicht

| Projekt | Vortragszeit | Stand |

|---|---|---|

| B-Human | 09:00 | |

| BM4OER | 09:25 | |

| GloBot | 09:50 | |

| Deep Anatomy | 10:15 | |

| HoloAI | 10:40 | |

| Mobile4D | 11:05 | |

| Tangible Sandbox Games | 11:30 | |

| Suturo | 11:55 | |

| systemXrunner | 12:20 | |

| Tiefsee | 12:45 | |

| Studium an der Uni Bremen | 13:10 |

Projektbeschreibungen

Das Projekt B-Human nimmt seit 2009 an den Roboterfußballwettbewerben des RoboCup und dessen regionalen Ablegern in der Standard Platform League teil. In dieser verwenden sämtliche Teams den humanoiden Roboter Nao der Firma SoftBank Robotics, um gleiche Hardwarevoraussetzungen zu gewährleisten. Somit konzentriert sich die Arbeit des Projektes vornehmlich darauf, die Software der Roboter weiterzuentwickeln und zu verbessern. Dies umfasst diverse verschiedene Aufgabenfelder, unter anderem Bilderkennung, Lokalisierung sowie autonome Agenten. Ziel ist es, auch dieses Jahr erfolgreich am RoboCup teilzunehmen und den Weltmeistertitel zu verteidigen.

Dem Projekt B-Human gelang es, aufbauend auf der Software der Vorgänger, bisher neunmal die RoboCup GermanOpen für sich zu entscheiden. Auch international ist B-Human äußerst erfolgreich: Insgesamt konnten wir sieben Weltmeistertitel nach Hause bringen, den letzten 2019 aus Sydney.

- Weitere Informationen unter https://www.b-human.de

Der Einsatz von Lehrmaterialien in Schulen beschränkt sich seit jeher fast ausschließlich auf Medien von kommerziellen Verlagen. Als mögliche Alternative existieren seit einiger Zeit offene Bildungsmedien, sogenannte Open Educational Ressources (kurz OER). Diese zeichnen sich vor allem durch die freie und wenig beschränkte Nutzung aus. Im Projekt BM4OER geht es darum, ob solch ein Modell auch in der realen Praxis eingesetzt und überleben kann. Dabei liegt der Fokus unseres Projektes auf Schulen der siebten bis zur zehnten Jahrgangsstufe im Bundesland Niedersachsen. Zentrale Fragestellungen, die innerhalb des Projektes zu beantworten sind, betreffen zum einen die nötige Qualitätssicherung, da sichergestellt werden muss, dass die Materialien einen gewissen Standard erfüllen. Zudem werden rechtliche Aspekte, die die mögliche Verwendung von OER im Schulbetrieb betreffen, erforscht. Abschließend muss eine valide Finanzierungsmethode erarbeitet werden, da offene Bildungsmedien keine direkten Erlöse erzielen. Darauf aufbauend sollen verschiedene Geschäftsmodelle evaluiert, sowie eine realistische Einschätzung zum Einsatz abgegeben werden. Das Ergebnis soll sowohl in einem wissenschaftlichen Paper vorgestellt werden, welches die Antworten auf die Fragestellungen beinhalten soll, als auch in einem interaktiven Prototyp, der den praktischen Einsatz eines OER Portals präsentieren soll.

Bisher kein Beschreibungstext eingereicht.

In Zusammenarbeit mit dem Fraunhofer MEVIS haben wir uns während der Projektzeit mit verschiedenen Aufgaben rund um das Thema Deep Learning befasst. Deep Learning bezeichnet hierbei eine Form von künstlichen neuronalen Netzen mit diversen Zwischenschichten, die am MEVIS für die Erkennung und Verarbeitung medizinischer Bilddaten verwendet werden. Beispiele für diese Bilddaten sind CT- und MRT-Bilder, in denen Knochen, Knorpel, Bänder, Organe oder Tumore erkannt werden sollen.

Innerhalb der Projektgruppe haben sich zwei Untergruppen zu verschiedenen Interessengebieten gebildet. Ein Teil hat sich die Verbesserung und Erweiterung der Software von MEVIS, dem MeVisLab, zum Ziel genommen. Die Arbeit mit neuronalen Netzen und das Einlesen von Daten soll vereinfacht und weitere neue Funktionen sollen zur Verfügung gestellt werden.

Der andere Teil legte den Schwerpunkt auf die Teilnahme an verschiedenen Challenges. Dabei wurden mithilfe des MeVisLab eigene neuronale Netze auf bereitgestellten Datensätzen trainiert, um das jeweilige Challengeziel bestmöglich zu erfüllen. Die bereitgestellten Datensätze sind Bilddaten, in denen Experten bestimmte Strukturen markiert haben. Die mit diesen Datensätzen trainierten neuronalen Netze sollen entsprechende Markierungen, so präzise wie möglich, in neue Bilddaten ohne Markierungen einfügen.

HoloAI steht für holographic Artificial Intelligence. Holografische Projektionen sind ein beliebtes Motiv in der Sciencefiction Pop-Kultur. In Star Wars gibt es mobile holografische Telefonie, im Spiel Half-Life wird man mit holografischen Assistenten durch das Tutorial geführt, und in Star Trek wird sogar ein holografischer Bordarzt eingesetzt. Das holoAI-Projekt hat als Ziel die Entwicklung eines holografischen Agenten, der interaktiv auf die Anfragen seiner Benutzer reagiert. Teil des Projekts sind sowohl die Gestaltung eines dreidimensionalen, humanoiden Avatars, als auch die Entwicklung eines leistungsstarken Backends unter Anwendung moderner KI-Technologie. Ausgestattet mit multimodaler Sensorik ist der Agent in der Lage auf Sprache, Mimik und Gestik von Menschen zu reagieren, sowie wiederkehrende Benutzer zu erkennen. Ansässig im Cartesium-Gebäude sollen Besucher begrüßt und über standortspezifische Fakten informiert werden. Der Aufbau ist Teil des Wissenschaftsschwerpunktes Mind, Media, Machines (MMM).

Mobile4D hat es sich mit seinen IT-Projekten zur Aufgabe gemacht, Länder in medizinischer Hinsicht und in Hinblick auf die humanitäre Sicherung zu unterstützen. Außerdem entwickeln wir Systeme um die Verbreitung von Krankheiten wie Malaria, die von Mosquitos übertragen werden, zu analysieren und ihnen vorzubeugen. Unsere jüngsten Projekte befassen sich mit der Früherkennung des schwierig diagnostizierbaren Dengue-Fieber und dem Entwickeln eines Systems zur akustischen Identifikation von mit Malaria infizierten Mosquitos.

Mit unseren Projekten stehen wir in engem Kontakt mit unseren Partnern in Thailand und Laos und haben im Wintersemester 19/20 wieder ein paar TeilnehmerInnen nach Bangkok geschickt um dort die Dengue Diagnose App für eine Betaphase zu etablieren.

Das Feld der Virtual Reality Anwendungen ist eine vergleichsweise neue und rapide wachsende Industrie. Während Entwickler Tracking, visuelle Qualität und Eingabegeräte konstant verbessern, gibt es einen Aspekt der noch nicht in vollem Umfang ausgeschöpft wird: Haptisches Feedback.

Wir vom “Tangible Sandbox Games” Masterprojekt haben untersucht, welche Effekte Multimodalität auf die Nutzererfahrung und Verhalten in VR hat. Um dies herauszufinden, haben wir mit der Unity Game-Engine ein Virtual-Reality Tower Defense Spiel entwickelt, welches sowohl in einer rein virtuellen, als auch in einer realen, physischen Sandbox spielbar ist.

Hierbei werden klassische Vive-Controller-Eingaben verglichen mit der Haptik einer realen Sandbox und der Ausnutzung der Hände in Leap Motion. Ein Vergleich von Nutzer- / Spielererfahrung und Performance sowie eine exploratorische Analyse der verschiedenen Spielweisen sollen uns Aufschlüsse über die Chancen einer haptischeren Umgebung eröffnen.

Bisher kein Beschreibungstext eingereicht.

Das Bachelorprojekt systemXrunner verbindet Spaß an Games mit Interesse an komplexen Hardware-Software-Systemen: Wir haben eine Game-Cartridge mit SD-Karten-Slot für das Nintendo Entertainment System (NES) entwickelt. Auf diese Weise muss man nicht ständig die Cartridge wechseln, wenn man ein anderes Spiel spielen will, sondern man kann seine gesamte Spielebibliothek auf einer einzigen SD-Karte speichern und über einen Microcontroller auf die NES laden. Innerhalb von Sekunden könnt ihr so bequem zwischen Super Mario Brothers, Legend of Zelda Mega Man und vielen weiteren wechseln.

Wenn ihr mehr wissen wollt über das System aus NES und Cartridge, über Embedded Software Development in Assembly oder einfach über Retro Games, dann kommt zum Stand der systemXrunner!

Das Projekt Tiefsee befasst sich mit diffusen Ausflüssen am Meeresgrund. Ziel ist es, diese Ausflüsse in einer Bildübertragung automatisiert zu detektieren. Zur Unterstützung findet eine digitale und experimentelle Nachstellung dieses Naturphänomens statt.

Kommen in Ausflüssen viele Partikel vor, können sich Phänomene wie die »Black Smoker«, die wahrscheinlich bekanntesten Unterwasserquellen ergeben. Bei diffusen Ausflüssen tritt hingegen Wasser ohne gut sichtbare Partikel aus. Es unterscheidet sich vom umgebenden Medium lediglich durch seine Temperatur oder seinen Salzgehalt. Hieraus ergeben sich unterschiedliche Brechungsindizes, die ein optisches Flimmern auslösen, vergleichbar mit heißer Luft über einem Kamin oder über Straßen an heißen Sommertagen. Diese Erscheinungen werden als »Schlieren« bezeichnet.

Für die Detektion werden in Python einzelne Bilder aus Videosequenzen von Ausfahrten mit Tauchrobotern entnommen und miteinander verglichen. Hiervon ausgehend wird bestimmt, ob sich der Hintergrund durch die Schliereneffekte in Subregionen der Bilder verschoben hat. Dies wird visuell hervorgehoben.

Im Bereich der Simulation werden Austritte und die damit verbundenen Effekte virtuell nachgestellt. Hierzu wurde ein eigener Renderer erzeugt. Ausgehend von Berechnungen in externen Programmen, in denen Austritte mit mehreren Phasen simuliert werden, wird im beim Rendering eine entsprechende Störung in den Raum eingefügt. Das Resultat sind optische Verzerrungen, die dem einer Schliere nahe kommen.

Experimentell wird versucht, unter Laborbedingungen und daher auch ohne Störfaktoren, die bei Aufzeichnungen vom Meeresgrund auftreten, Schlieren nachzustellen. Hierzu werden unterschiedliche Flüssigkeiten in ein Aquarium oder Becken eingeführt und das Ergebnis mit einer Kamera aufgezeichnet. Das Videomaterial kann zur Unterstützung und Verifikation der Ergebnisse der Detektion genutzt werden. Gleichzeitig entsteht auch Referenzmaterial für die Simulation, die die Möglichkeit erhält, den Versuchsaufbau nachzustellen und reale Ergebnisse mit dem Simulierten zu vergleichen. Es werden auch Erkenntnisse gesammelt, auf welche Ausstattung bei einem Unterwasserfahrzeug geachtet werden muss, das über eine automatische Schlierenerkennung verfügen soll.

- Projektbetreuung Prof. Dr. Ralf Bachmeyer

- Projektbetreuung Prof. Dr. Gabriel Zachmann

Ausstattung

Barrierefreiheit

Die erste Etage ist vom Haupteingang über Fahrstühle auf der rechten Seite des Hauptflures erreichbar.

Hinter dem Senatssaal befindet sich in einer Reihe mit den weiteren Toiletten ein barrierearmes WC.

Geschlechtsneutrale Toiletten

Direkt neben dem Projekttag in der Ebene 1 befinden sich zwei geschlechtsneutrale Toiletten, die von allen Menschen verwendet werden können.

Getrennte Einrichtungen finden sich am anderen Ende des Gebäudes.

Still-, Wickel- und Sanitätsraum

Direkt gegenüber des Eingangs vom Senatssaal befindet sich ein Still-, Wickel- und Sanitätsraum. Hier stehen unter anderem eine Liege und ein Waschbecken zur Verfügung. Verwendetes Material bitte in das beiliegende Logbuch eintragen.

Anfahrt

Anreise mit dem Zug

Wenn Sie den Bremer Hauptbahnhof in Richtung Süden (Stadtmitte) verlassen, finden sie Taxis und Straßenbahnen auf dem direkt vor Ihnen liegenden Bahnhofsvorplatz.

Nehmen Sie zur Weiterfahrt zur Universität die Straßenbahn Linie 6 in Richtung Universität und steigen sie an der Haltestelle »Universität/Zentralbereich« aus.

Bei einer Fahrt mit dem Taxi zahlen Sie ca. 15€.

Anreise mit dem Auto

Wenn Sie von der A1 kommen, müssen Sie am Bremer Kreuz auf die A27 in Richtung Bremen-Bremerhaven wechseln. Verlassen Sie die A27 an der Abfahrt Universität/Horn-Lehe und fahren Sie in Richtung Zentrum/Universität.

Auf dem Campus und im Technologiepark Universität stehen in der Regel ausreichend Parkplätze (ab 1€/Tag) zur Verfügung.